NTU Singapore: il sistema di post-elaborazione robotico rimuove la polvere residua dalle parti stampate in 3D

I ricercatori della Nanyang Technological University di Singapore hanno scritto un documento, intitolato ” Sviluppo di un sistema robotico per il decaking automatizzato di parti stampate in 3D “, sul loro lavoro nel tentativo di aggirare un significativo collo di bottiglia nella post-elaborazione della stampa 3D. Nei processi AM a letto di polvere , come il Multi Jet Fusion (MJF) di HP, il decaking consiste nel rimuovere la polvere residua che si attacca alla parte una volta rimossa. Questo è per lo più completato da operatori umani che usano i pennelli, e per le tecnologie AM che possono produrre centinaia di pezzi in un unico lotto, ciò richiede ovviamente molto tempo. Il lavoro manuale come questo è un componente di costo significativo dei processi di fusione del letto di polvere.

“Combinando l’apprendimento profondo per la percezione 3D, la progettazione meccanica intelligente, la pianificazione del movimento e il controllo della forza per i robot industriali, abbiamo sviluppato un sistema in grado di decadere automaticamente le parti in modo rapido ed efficiente. Attraverso una serie di esperimenti di decaking eseguiti su parti stampate da una stampante Multi Jet Fusion, abbiamo dimostrato la fattibilità del decaking robotico per la produzione di massa basata sulla stampa 3D ”, hanno scritto i ricercatori.

Un classico problema robotico è il bin picking, che comporta la selezione e la rimozione di una parte da un contenitore. I ricercatori della NTU hanno stabilito che la percezione 3D, che “riconosce gli oggetti e determina le loro pose 3D in uno spazio di lavoro”, sarebbe importante per costruire il loro sistema di raccolta dei rifiuti. Hanno anche usato un manipolatore controllato in base alla posizione come sistema di base per garantire un controllo del movimento conforme.

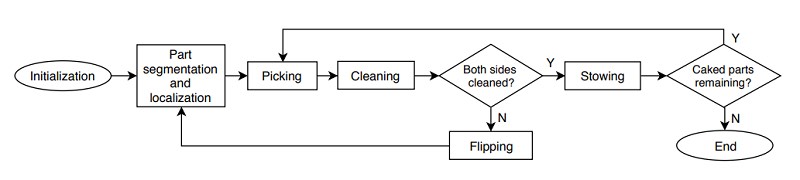

Il sistema robotico del team NTU esegue cinque passaggi generali, a partire dall’attività di raccolta dei bidoni, in cui una ventosa preleva una parte incrostata dal contenitore di origine. La parte inferiore viene pulita strofinandola su un pennello, quindi capovolta e l’altro lato viene pulito. Il passaggio finale consiste nel posizionare la parte pulita nel contenitore di destinazione.

Ogni passaggio ha le sue difficoltà; ad esempio, le parti incrostate si sovrappongono e sono difficili da rilevare, poiché sono per lo più dello stesso colore della polvere e la polvere residua e le parti hanno proprietà fisiche diverse, il che rende difficile manipolare le parti con un robot industriale controllato in posizione .

“Affrontiamo queste sfide sfruttando rispettivamente (i) i recenti progressi nel Deep Learning per la visione 2D / 3D; e (ii) progettazione meccanica intelligente e controllo della forza “, ha spiegato il team.

I tre passaggi successivi – pulizia del pezzo, rotazione e pulizia dell’altro lato – sono difficili a causa del “controllo dei contatti” tra le parti, il robot e il sistema di spazzolatura. Per questo, i ricercatori hanno usato il controllo della forza per “eseguire azioni conformi”.

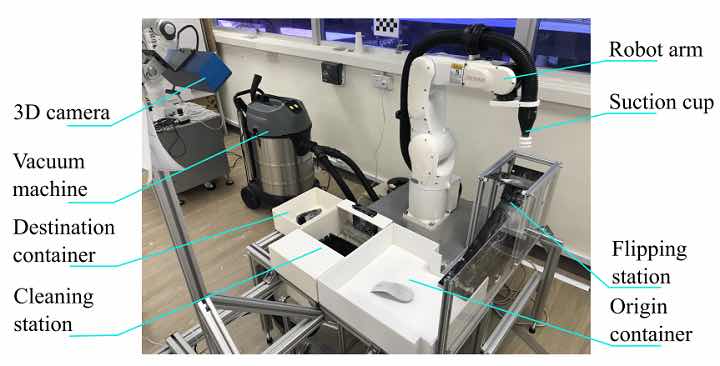

La loro piattaforma robotizzata realizzata con componenti standard:

1 Denso VS060: manipolatore industriale a sei assi

1 sensore ATI Gamma Force-Torque (F / T)

1 fotocamera 3D Ensenso N35-802-16-BL

1 sistema di aspirazione alimentato da una macchina per vuoto Karcher NT 70/2

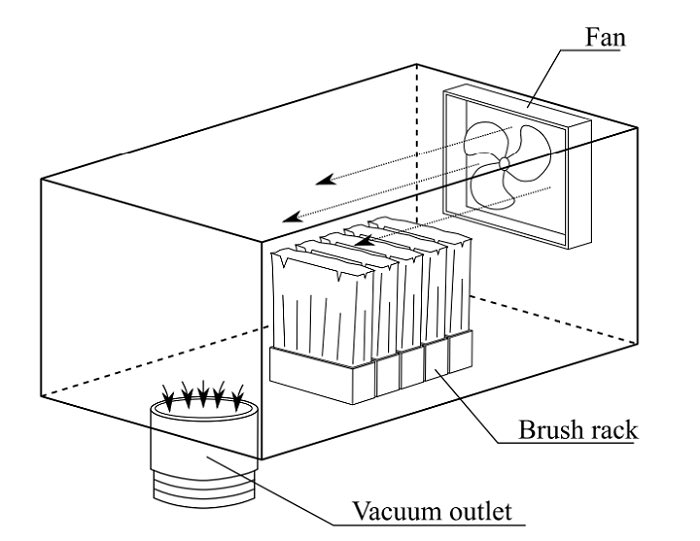

1 stazione di pulizia

1 stazione lanciante

La fotocamera aiuta a evitare collisioni con l’ambiente, gli oggetti e il braccio del robot e “per massimizzare gli angoli di visione”. Un sistema a ventosa è risultato essere il più versatile e lo hanno progettato su misura per generare un flusso d’aria e un vuoto elevati al fine di recuperare polvere riciclabile, ottenere una forza sufficiente per il sollevamento e trattenere saldamente le parti durante la spazzolatura.

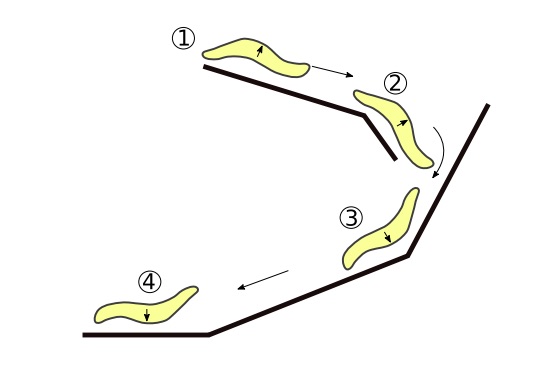

Hanno scelto una stazione di lancio passivo (non è necessario alcun attuatore) per modificare l’orientamento della parte. La parte viene lasciata cadere dalla parte superiore della stazione e si sposta lungo i cursori di guida. Viene capovolto quando raggiunge il fondo ed è quindi pronto per essere raccolto dal braccio del robot.

Una macchina a stati e una serie di moduli compongono il sistema software. La macchina sceglie il modulo giusto da eseguire al momento giusto, e sceglie anche la “parte più fattibile” per il decaking nella sequenza.

“La macchina a stati ha accesso a tutte le informazioni essenziali del sistema, inclusi tipi, pose, geometrie e pulizia, ecc. Di tutti gli oggetti rilevati nella scena. Ogni modulo può richiedere queste informazioni per rendersi conto del suo comportamento. Di conseguenza, questo design è generale e può essere adattato a molti altri tipi di parti stampate in 3D “, hanno spiegato i ricercatori.

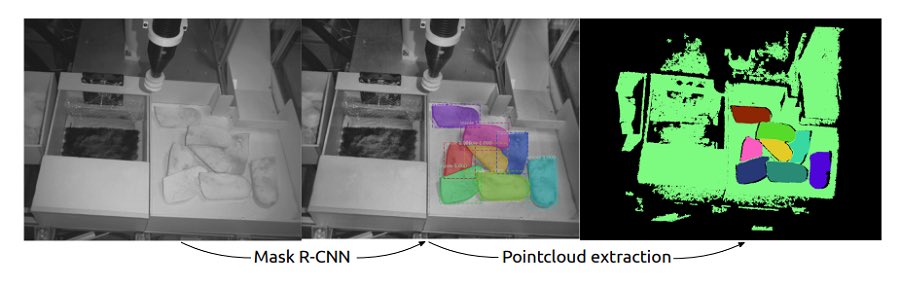

I moduli hanno diversi compiti, come la percezione, che identifica e localizza gli oggetti visibili. La prima fase di questa attività utilizza una rete di deep learning per completare il rilevamento e la segmentazione delle istanze, mentre la seconda utilizza una maschera di segmentazione per estrarre i punti 3D di ciascun oggetto e “stimare la posa dell’oggetto”.

Esempio del modulo di rilevamento oggetti basato sulla maschera R-CNN. Le caselle di delimitazione stimate e le segmentazioni delle parti sono rappresentate in diversi colori ed etichettate con la proposta di identificazione e la fiducia. Rifiutiamo il rilevamento con una sicurezza inferiore al 95%.

“In primo luogo, una rete neurale profonda basata sulla maschera R-CNN classifica gli oggetti nell’immagine RGB ed esegue la segmentazione delle istanze, che fornisce una classificazione degli oggetti pixel-saggia”, hanno scritto i ricercatori.

L’apprendimento del trasferimento è stato applicato al modello pre-addestrato, in modo che la rete potesse classificare una nuova classe di oggetti nel cestino con un alto tasso di rilevamento.

“In secondo luogo, la stima delle parti viene eseguita stimando i riquadri di delimitazione e calcolando i centroidi delle nuvole di punti segmentate. La nuvola di punti di ciascun oggetto viene perfezionata (ovvero rimozione di valori anomali statistici, lisciatura normale, ecc.) E utilizzata per verificare se l’oggetto può essere raccolto mediante aspirazione (ovvero le superfici esposte devono essere più grandi dell’area della ventosa). ”

I moduli di prelievo e pulizia sono composti da più primitivi di movimento, il primo dei quali è il prelievo o l’aspirazione. Il robot raccoglie le parti con superfici quasi piane ed esposte spostando la ventosa sulla parte e il controllo di forza conforme indica quando arrestare il movimento verso il basso. Verifica se l’altezza della ventosa è stata fermata all’altezza prevista, quindi solleva la coppa, mentre il sistema “controlla costantemente il sensore di coppia di forza” per assicurarsi che non vi siano collisioni.

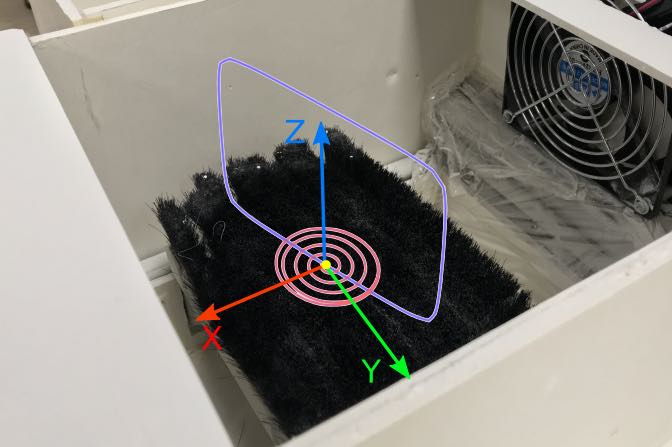

La pulizia dei primitivi di movimento rimuove detriti e polvere residui da parti stampate in 3D quasi piatte. La parte è posizionata sopra il portaspazzole e il controllo della forza conforme sposta il robot fino a quando non viene a contatto. Per mantenere il contatto tra la parte e le spazzole, viene utilizzato uno schema ibrido di controllo della posizione / forza.

“Le traiettorie di pulizia sono pianificate secondo due schemi: spirale e rettangolo”, hanno spiegato i ricercatori. “Mentre il movimento a spirale è adatto per la pulizia di superfici quasi piane, il movimento del rettangolo aiuta a rimuovere la polvere in aree concave.”

Una combinazione di percorsi a spirale e rettangolo viene utilizzata per la pulizia dei movimenti. I percorsi a spirale sono in rosso. Il punto giallo indica il centroide delle parti all’inizio del movimento. I percorsi a spirale vengono modificati in modo che continuino a circondare il punto dopo aver raggiunto un raggio massimo. Il percorso del rettangolo è in blu, i parametri includono larghezza, altezza e direzione nel piano XY.

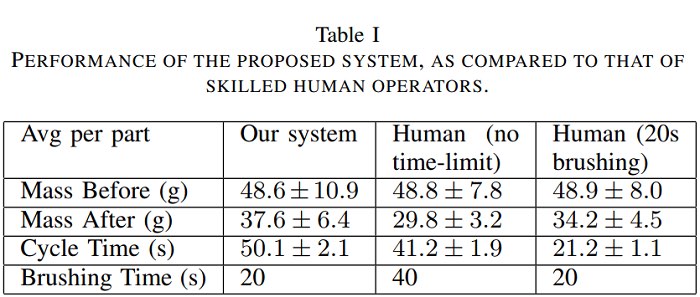

Il team ha testato il proprio sistema utilizzando dieci solette per scarpe stampate in 3D. La sua qualità di pulizia è stata valutata pesando le parti prima e dopo la pulizia, ei ricercatori hanno riportato il tempo di funzionamento del sistema in un ambiente realistico, rispetto a operatori umani qualificati.

In termini di qualità della pulizia, le prestazioni del sistema robotizzato erano quasi due volte inferiori, il che “ha sollevato dubbi su come migliorare ulteriormente l’efficienza delle attività”. Gli umani hanno impiegato oltre il 95% dei tempi di esecuzione sulla spazzolatura, mentre il sistema ha eseguito azioni di spazzolatura solo il 40% dei tempi di esecuzione; ciò è dovuto alle “abilità superiori di una persona nell’esecuzione di sensazioni e manipolazioni abili”. Ma la qualità della pulizia è stata ridotta quando il tempo di spazzolatura è stato limitato a 20 secondi, il che potrebbe significare che la qualità migliorerebbe aggiornando la stazione di pulizia e “prolungando la durata della spazzolatura”.

Inoltre, gli umani hanno ottenuto risultati più coerenti, in quanto sono in grado di regolare i loro movimenti secondo necessità. I ricercatori ritengono che l’aggiunta di un modulo di valutazione della pulizia, completo di una seconda fotocamera 3D, al loro sistema migliorerebbe questo.

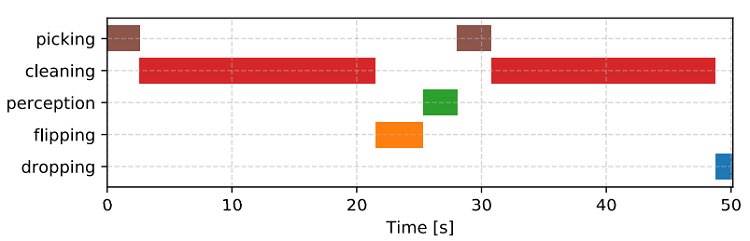

Rappresentazione della linea temporale media delle azioni utilizzate per la pulizia.

“Abbiamo notato che il nostro robot ha funzionato alla velocità massima del 50% e tutti i movimenti sono stati pianificati online. Pertanto, le prestazioni del sistema potrebbero essere ulteriormente migliorate ottimizzando questi moduli “, ha scritto il team. “Inoltre, il nostro modulo di percezione era in esecuzione su una CPU, le implementazioni di un migliore hardware di elaborazione migliorerebbero così la velocità di percezione.”

Sebbene questi risultati siano principalmente positivi, i ricercatori hanno in programma di convalidare ulteriormente il sistema migliorando il design dell’effettore finale, ottimizzando l’efficienza delle attività e adattandolo al lavoro con parti stampate in 3D più generali.