Google AI vede la tartaruga stampata in 3D come un fucile, i ricercatori del MIT spiegano perché

I ricercatori del MIT hanno condotto un’indagine su “esempi contraddittori”, oggetti che possono ingannare la visione della AI l’intelligenza artificiale nel pensare ad un oggetto è qualcosa di completamente diverso. I ricercatori hanno fatto una tartaruga stampata 3D che ha ingannato l’Inception-v3 di Google il quale è stato indotto a pensare che fosse una pistola, anche da più angolazioni.

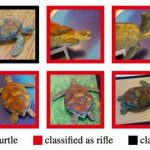

Date un’occhiata alla tartaruga stampata 3D sopra, e farete fatica a trovare qualcosa di particolarmente minaccioso. Forse il filamento di stampa 3D usato per farlo era leggermente tossico, ma alla fine, è solo una tartaruga di plastica.

Ma non è come il classificatore di immagini AI di Inception-v3 di Google la vede . Attraverso gli occhi del sistema di intelligenza artificiale, la creatura marina a stampa 3D innocente sembra proprio un fucile.

Il supporto stampato in 3D è quello che è conosciuto come un esempio contraddittorio, qualcosa progettato per ingannare un sistema di intelligenza artificiale nel pensare che sia completamente diverso. In questo caso, i ricercatori del MIT hanno progettato la tartaruga di plastica per far credere all’AI di Google di trovarsi di fronte ad un’arma pericolosa.

Ovviamente è abbastanza divertente a un certo livello: chissà quanti milioni di dollari vengono pompati nei sistemi di classificazione delle immagini, ma non si riesce a distinguere un giocattolo di plastica da un fucile. E ‘la stessa impressionante ma divertente qualità che ha reso quelle immagini di Google DeepDream incombenti così ipnotizzante.

Ma oggetti contraddittori – o immagini contraddittorie nel mondo 2D – sono in realtà molto significative e potenzialmente molto fastidiose.

I sistemi a rete neuronale AI come l’Inception-v3 di Google sono, ovviamente, incredibilmente intelligenti. Ma lavorano su complessi algoritmi fatti dall’uomo, non sul buon senso. E se hai familiarità con le regole e la logica precisi di un sistema AI, puoi potenzialmente sfruttarlo.

Poiché l’Inception-v3 di Google è open source, i ricercatori di MIT – Anish Athalye, Logan Engstrom, Andrew Ilyas e Kevin Kwok, insieme conosciuti come “labsix”, erano in posizione perfetta per sfruttarlo, studiando i criteri esatti per il riconoscimento del “fucile” e cercare di in qualche modo di ingannare queste caratteristiche in qualcosa di non molto pericoloso: una tartaruga.

I ricercatori del MIT non sono i primi a creare oggetti contraddittori, naturalmente. Le persone possono usare dei trucchi per ingannare i sistemi di riconoscimento del viso in errore nell’identificare una persona, è qualcosa che limita i servizi di sicurezza attuali.

Per la maggior parte degli oggetti e delle immagini contraddittorie, però, il “trucco” funziona solo da certi angoli. Puoi ingannare una rete neurale nel pensare che un sacchetto di patatine sia un volto da un certo angolo, ma muovendolo leggermente l’AI probabilmente correggerà il suo errore.

Ma la tartaruga stampata 3D, così come gli altri esempi 3D dei ricercatori MIT, sono diversi. In realtà fanno impazzire la Google AI da più angoli, piuttosto che da uno, rendendoli molto più devastanti nel risultato.

Oltre alla tartaruga che sembra un fucile, labsix ha anche stampato in 3d una palla da baseball che viene riconosciuto come un caffè espresso . Hanno anche fatto dei modelli digitali di una palla da baseball che può apparire come una lucertola verde, un cane che l’AI pensa sia un airone stellato e altri altri esempi.

I ricercatori hanno potuto facilmente fare più esempi di questi oggetti dopo aver creato un algoritmo per “produrre in modo affidabile oggetti fisici 3D che sono contraddittori da ogni punto di vista”, lavorando con precisione quasi del 100 per cento. Chiamano questo algoritmo “Expectation Over Transformation” (EOT).

In un certo senso, la squadra è soddisfatta dei suoi successi, ma è anche preoccupata per i risultati.

“[EOT] non dovrebbe essere in grado di prendere un’immagine, variare leggermente i pixel e confondere completamente la rete neurale”, ha dichiarato Athalye . “Le reti neurali migliorano tutte le tecniche precedenti in termini di prestazioni, ma data l’esistenza di questi esempi contraddittori, dimostra che non capiamo davvero cosa sta succedendo”.

Naturalmente, questo non è solo divertente per i ricercatori del MIT. Credono che la loro ricerca dimostri senza dubbio che “gli esempi contraddittori sono una preoccupazione pratica per i sistemi del mondo reale”.

Se, ad esempio, gli hacker potessero accedere ai complessi algoritmi che stanno dietro ad un sistema AI non aperto, ad esempio “gli occhi” di un’auto-guida, potrebbero essere in grado di provocare danni reali manipolando oggetti reali in parole povere provocare incidenti ingannando la guida autonoma.

Tutto ciò potrebbe sembrare una possibilità remota, dopo tutto, l’Inception-v3 aperto di Google non viene utilizzato per applicazioni critiche, ma la ricerca MIT mette certamente in evidenza la fallibilità dei sistemi AI visivi.

Anche la squadra prevede di guardare ulteriormente nella creazione di oggetti contraddittori che sfidano i sistemi AI i cui meccanici sono nascosti.